[Virtual Event] GenAI Streamposium: Learn to Build & Scale Real-Time GenAI Apps | Register Now

Pipelines de données de streaming

Les pipelines de streaming permettent l'ingestion, le traitement et le déplacement continus des données, de leur(s) source(s) vers leur destination, au moment même où elles sont générées. Connue également sous le nom de streaming ETL ou de flux de données en temps réel, cette technologie est utilisée dans de nombreux secteurs pour transformer les bases de données en flux permettant l'ingestion et le traitement en continu des données. Elle permet d'accélérer leur fourniture, leur utilisation et leur analyse en temps réel.

Créée par les fondateurs d'Apache Kafka, la plateforme de streaming de données de Confluent automatise les pipelines de données en temps réel avec plus de 120 intégrations prédéfinies, de puissantes fonctionnalités de sécurité et de gouvernance et d'innombrables cas d'usage.

What Are Streaming Data Pipelines?

- Mobile banking apps

- GPS apps that recommend driving routes based on live traffic information

- Smartwatches that track steps and heart rate

- Personalized real-time recommendations in shopping or entertainment apps

- Sensors in a factory where temperatures or other conditions need to be monitored to prevent safety incidents

La puissance des données en temps réel. À grande échelle.

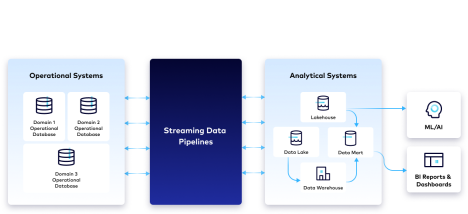

Les pipelines de données de streaming prennent en charge une variété de formats de données provenant de sources hétérogènes, et sont capables de gérer plusieurs millions d'événements par seconde. Ils éliminent les silos en diffusant les données dans plusieurs environnements, créent des flux de données en temps réel utiles aux entreprises, et sont souvent utilisés pour relier deux types de systèmes :

- Les systèmes opérationnels où des données de différents formats sont stockées dans des bases de données opérationnelles hébergées on prem ou dans le cloud.

- Les systèmes analytiques où des données sont stockées dans un entrepôt ou un lac de données et utilisées à des fins d'analyse en temps réel, de reporting, de création de tableaux de bord BI et d'autres types d'initiatives en matière de science des données.

Pourquoi se tourner vers les pipelines de données de streaming ?

Flux de données en temps réel

En déplaçant les données de leur source vers les systèmes cibles et en les transformant en temps réel, les pipelines de données de streaming fournissent des données récentes et précises dans un format facilement utilisable. Cela améliore l'agilité des développeurs et permet aux entreprises de disposer d'informations qui les aident à prendre des décisions éclairées et proactives. Elles sont ainsi capables de réagir intelligemment et en temps réel aux événements qui se produisent, ce qui réduit les risques, génère des économies voire des revenus supplémentaires, et garantit à leurs clients une expérience personnalisée.

Stream Processing en temps réel

Le traitement de flux présente des avantages significatifs par rapport au traitement par lots, en particulier en termes de latence des données. Les pipelines ETL traditionnels ingèrent et transforment les données sous forme de lots périodiques, généralement la nuit. À l'inverse, le traitement des flux permet de transformer les données en continu et à la volée, tout en les transférant vers les systèmes cibles au fur et à mesure qu'elles sont générées. En plus de minimiser la latence, cela permet de streamer des données pour alimenter des cas d'usage tels que la détection des tentatives de fraude en temps réel. Pour plus d’informations sur les différents types de traitement des données, consultez notre page de comparaison entre le traitement par lots et le traitement de flux.

Développement de pipeline agile

Les entreprises n'ont plus besoin de développer manuellement des pipelines de données individuels. Elles consacrent moins de temps au dépannage, et peuvent exploiter les données de manière innovante et les adapter à l'évolution de leurs besoins. En réduisant la dette technique et les besoins de maintenance, les équipes parviennent également, à terme, à mieux gérer l'utilisation des données de l'entreprise.

Une architecture cloud évolutive et tolérante aux pannes

Grâce à la flexibilité inhérente au cloud (mise à l'échelle automatique), les consumers peuvent se concentrer sur l'utilisation des données, et non sur la gestion de l'infrastructure. Les événements circulant en continu, les entreprises bénéficient d'une tolérance aux pannes qui les protège contre les pertes de données, leur permet de réagir de manière réactive et leur évite de rater des opportunités.

Fonctionnement des pipelines de données de streaming

Les pipelines de données de streaming exécutent en continu une série d'étapes, qui inclue l'ingestion et le nettoyage des données brutes au moment où elles sont générées, et la personnalisation des résultats pour répondre aux besoins de l'entreprise.

Ingestion

Les données en temps réel sont ingérées à partir de sources de données on prem et basées sur le cloud (applications, bases de données, capteurs IoT) dans différents formats.

Stream Processing

La manipulation, le nettoyage, la transformation et la préparation éliminent les données inutilisables du pipeline et préparent les autres pour le suivi, l'analyse et d'autres utilisations en aval.

Normalisation des schémas

Pour pouvoir préparer et analyser les données de streaming, celles-ci doivent être structurées selon un schéma standard qui détermine comment les données sont organisées. La mise en place d'un tel schéma permet une compatibilité évolutive des données, tout en réduisant la complexité opérationnelle.

Surveillance des flux

Pour mieux comprendre les systèmes qui génèrent des événements continus, la plupart des entreprises appliquent les concepts d'observabilité et de surveillance aux flux événementiels. La possibilité de voir ce qui se passe au niveau des flux (par exemple, combien de messages sont produits ou consommés au fil du temps) permet de s'assurer que ceux-ci fonctionnent correctement et qu'ils fournissent des informations en temps réel, sans perte de données.

Broker de messages

Un broker de messages gère le service et la livraison des données tout au long du pipeline de streaming, en garantissant un traitement exactly-once et en préservant l'intégrité et la traçabilité des données.

Provisionnement

Les données sont mises à disposition de différentes cibles et de consumers en aval, qui ont souvent besoin d'un accès simultané à des données historiques et à jour. Pour répondre à cette exigence, de nombreuses architectures prévoient de stocker les données à la fois dans les lacs et entrepôts de données et dans le broker de messages lui-même.

5 principes pour créer des pipelines de données de streaming modernes

1. En temps réel

Utilisez des flux de données et une plateforme de streaming pour disposer de référentiels de données réutilisables et fiables, au lieu de transférer des données périodiques peu fiables vers des référentiels externes. Utilisez des schémas pour standardiser la gestion des données entre les producers et les consumers, et ainsi garantir leur compatibilité.

2. Décentralisé

Offrez une propriété des données décentralisée et orientée domaine afin que les équipes qui utilisent vos données puissent créer, partager et réutiliser des flux de données. Donnez aux équipes qui travaillent avec des données en libre-service la possibilité de publier des flux de données et de s'y abonner facilement.

3. Déclaratif

Tirez parti d'un langage déclaratif comme le langage SQL pour spécifier le flux logique de vos données (d'où elles viennent et où elles vont) au lieu de laisser l'infrastructure gérer automatiquement les changements d'échelle des données, le tout sans avoir à gérer les détails opérationnels de bas niveau.

4. Orienté développeur

Combinez des pratiques de développement agile et une approche CI/CD pour permettre à vos équipes de créer des flux de données modulaires et réutilisables pouvant être versionnés indépendamment, et développés, testés et déployés dans différents environnements. Facilitez la collaboration entre des professionnels dotés de compétences différentes à l'aide d'outils compatibles avec les IDE (environnements de développement intégrés) visuels et les éditeurs de code. Ces outils se distinguent des outils ETL traditionnels, généralement conçus pour les non-développeurs.

5. Gouverné

Jonglez facilement avec les différentes normes en matière d'observabilité, de sécurité, de gestion des politiques et de conformité des données. Garantissez la visibilité, la transparence et la compatibilité de vos données grâce à des fonctionnalités intuitives de recherche et de découverte qui permettront à vos développeurs et à vos ingénieurs d'innover plus rapidement.

Exemples de cas d'usage

Migration vers le cloud

Grâce aux pipelines de données de streaming, qui leur permettent de connecter et de synchroniser en temps réel plusieurs bases de données (qu'elles soient on prem ou multicloud), les entreprises peuvent tirer parti d'outils cloud native et migrer ou moderniser leurs opérations de développement d'applications. Les événements peuvent être traités et enrichis avec d’autres flux afin d'alimenter de nouvelles applications, et de réduire les besoins de maintenance ainsi que le coût total de possession des bases de données héritées. Pour en savoir plus, vous pouvez regarder notre démonstration, dans laquelle un connecteur Oracle CDC transmet les modifications d’une base de données héritée vers une base de données cloud native comme MongoDB, en utilisant le traitement des flux pour détecter les tentatives de fraude en temps réel.

Analyse en temps réel

Les pipelines de données de streaming offrent aux entreprises des informations précieuses en diffusant des données depuis des systèmes on prem vers des entrepôts de données basés sur le cloud. Ils ouvrent ainsi la voie à des processus d'analyse en temps réel, de modélisation pour le ML, de reporting et de création de tableaux de bord BI. Le transfert des charges de travail vers le cloud apporte flexibilité, agilité et rentabilité, que ce soit en matière de calcul ou de stockage. Voici une démonstration présentant l'utilisation de PostgreSQL CDC pour streamer des données client, le traitement des flux pour transformer les données en temps réel, et un connecteur Snowflake pour les entreposer à des fins d'analyse et de reporting ultérieurs.

Optimisation SIEM

Les pipelines de données de streaming fournissent des données contextuelles qui permettent de mieux appréhender la situation, et aident à automatiser et à orchestrer la détection des menaces, à réduire les faux positifs et à adopter une attitude proactive face aux cyberattaques. Consultez cette page pour en savoir plus sur la façon dont la consolidation, la catégorisation et l'enrichissement des données (journaux, données réseau, données télémétriques et issues de capteurs, événements en temps réel) peuvent fournir aux équipes les bonnes données au bon moment, et ainsi leur permettre de les surveiller et d'assurer leur sécurité.

Accès aux données de mainframe

Les pipelines de données de streaming peuvent permettre d'accéder aux données critiques du système d'enregistrement, en fournissant un accès en temps réel aux données de mainframe combinées à d'autres données. Ils permettent de briser les silos et d'alimenter de nouvelles applications, d'augmenter la portabilité des données entre différents systèmes et de réduire les coûts MIPS et de mise en réseau. Pour en savoir plus, cliquez ici.

Pourquoi choisir Confluent ?

L'acheminement direct des données de leur source vers les systèmes cibles crée des connexions point à point, qui sont peu évolutives et dont la sécurisation et la maintenance sont souvent coûteuses. Confluent propose une plateforme de streaming de données entièrement gérée et basée sur Apache Kafka, qui alimente les processus d'intégration des données et de création de pipelines de streaming. Grâce à Confluent, vous pouvez dissocier les producers et les consumers de données sans avoir à vous préoccuper d'harmoniser des systèmes hétérogènes.

Confluent propose plus de 120 connecteurs sources et cibles préconfigurés qui vous aideront à intégrer et à streamer vos données entre divers systèmes au sein d'environnements hybrides et multicloud. Réduisez votre temps d'ingénierie (de 6 mois à plusieurs années) et vos frais opérationnels en déployant des connecteurs entièrement gérés qui fournissent à vos équipes des données en libre-service, où et quand elles en ont besoin. En outre, vous pouvez traiter et transformer vos flux de données en temps réel avec ksqlDB et garantir la qualité et la conformité de vos données avec Stream Governance. Stream Designer de Confluent est une interface utilisateur visuelle sans code qui vous aide à créer, tester et déployer des pipelines de données de streaming en quelques minutes.