[Virtuelles Event] GenAI Streamposium: Lerne, Echtzeit-GenAI-Apps zu entwickeln und zu skalieren | Jetzt registrieren

Streaming-Anwendungen

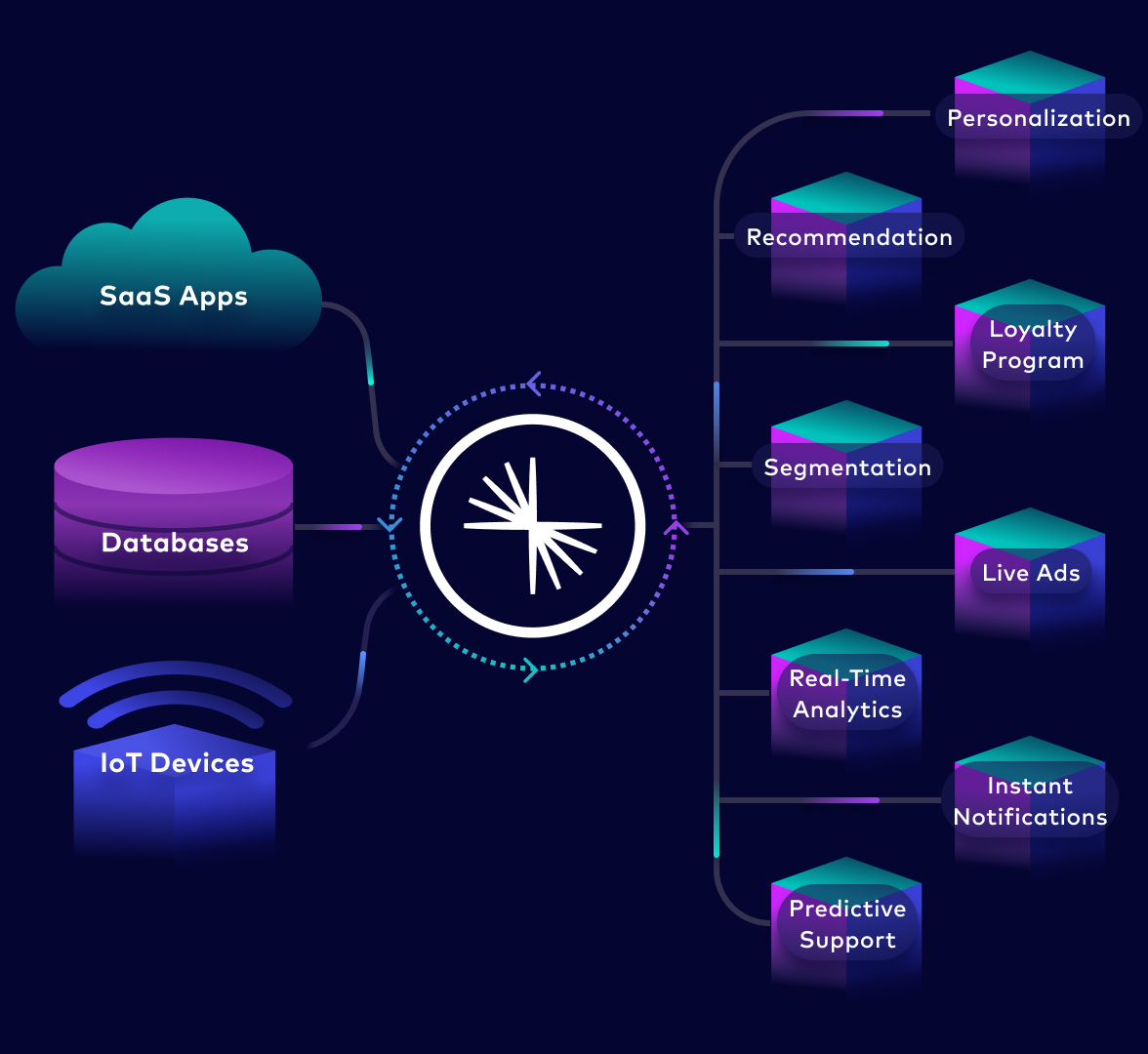

Zeitaufwand für die Suche nach Daten, den Massenexport über Daten-APIs und die mühsame Programmierung von Punkt-zu-Punkt-Integrationen reduzieren. Eine neue Kategorie von Event-getriebenen Echtzeitanwendungen erstellen, die modular, kontextsensitiv, hoch skalierbar und ausfallsicher sind.

Datennutzung und Services neu gestalten

Durch die Überwindung der Komplexität von Datenintegration und Datenzugriff kann das Potenzial von Microservices voll ausgeschöpft werden. Der reibungslose Zugriff auf wiederverwendbare Datenprodukte beschleunigt die Anwendungsentwicklung.

Enge Kopplungen und API-Wildwuchs verhindern

Eine zentrale Source of Truth gibt allen Services das aktuellste und genaueste Gesamtbild der Datenlage

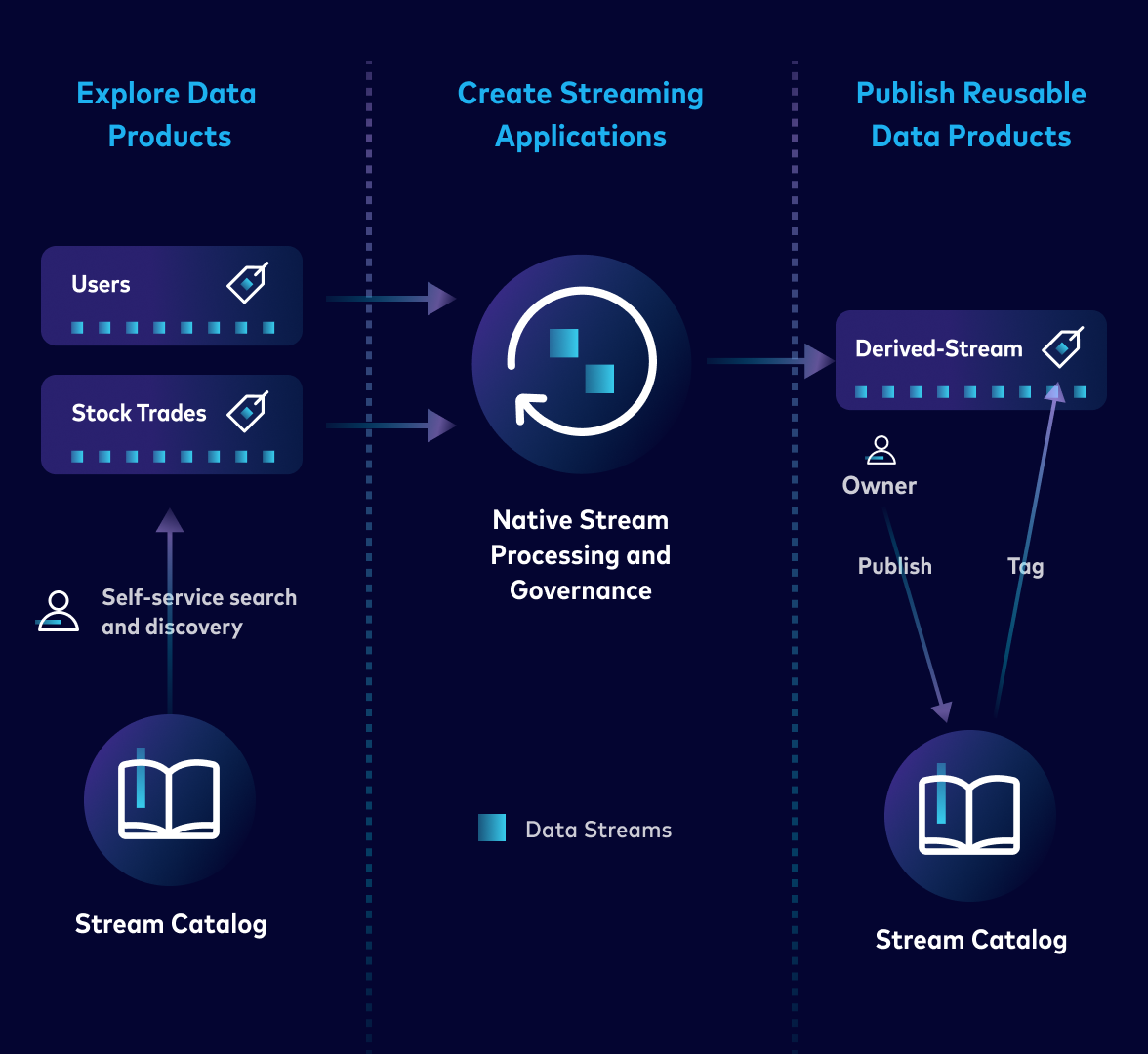

Datenautonomie für Entwickler

Mit einem Self-Service-Zugriff auf qualitativ hochwertige Datenprodukte erhalten Entwickler-Teams mehr Kontrolle über ihren Datenbedarf

Modernisieren im eigenen Tempo

Monolithen schrittweise in Microservices umwandeln, ohne Beeinträchtigung bestehender Anwendungen und Infrastrukturen

Verkürzung der Time-to-Market

Mit serverlosem Streaming können „Lightweight-Apps“ einfach erstellt und wieder entfernt werden. Daten-Workflows können mühelos erstellt, getestet und wiederverwendet werden, ohne sich mit der Infrastruktur herumschlagen zu müssen

Warum Confluent

Kontextsensitive Microservices erstellen und mit der sichersten, zuverlässigsten und skalierbarsten Daten-Streaming-Plattform operative und analytische Anwendungsfälle mit Echtzeitdaten ermöglichen.

Event-getriebene Architektur

Echtzeit-Events erfassen und Geschäftslogiken sofort anwenden, damit Anwendungen auf jedes Event entsprechend reagieren können

Unveränderliche Daten und Vorhaltung

Unbegrenzte Speicherung und Vorhaltung in einer zentralen Source-of-Truth aller Daten, so dass sie nach Bedarf abgerufen, kombiniert und wiedergegeben werden können

Entkoppeltes Design

Kommunikations-Bottlenecks beseitigen durch die Veröffentlichung wiederverwendbarer Daten, damit jeder Service auf Events reagieren kann, sobald sie entstehen

Vordefinierte Data Contracts

Schemakompatibilität, Versionskontrolle, Integrität und Qualität sicherstellen und Streaming-API mit AsyncAPI deklaratorisch spezifizieren

Sofortige Datenverarbeitung nach Generierung

Stateful- und Stateless-Verarbeitung unmittelbar nach Datenerstellung, um historische und Echtzeit-Datenströme während der Verarbeitung zusammenzuführen

Schnell, zuverlässig und flexibel

Billionen von Messages pro Tag verarbeiten, Datenkonsistenz und -integrität garantieren und in der bevorzugten Programmiersprache arbeiten

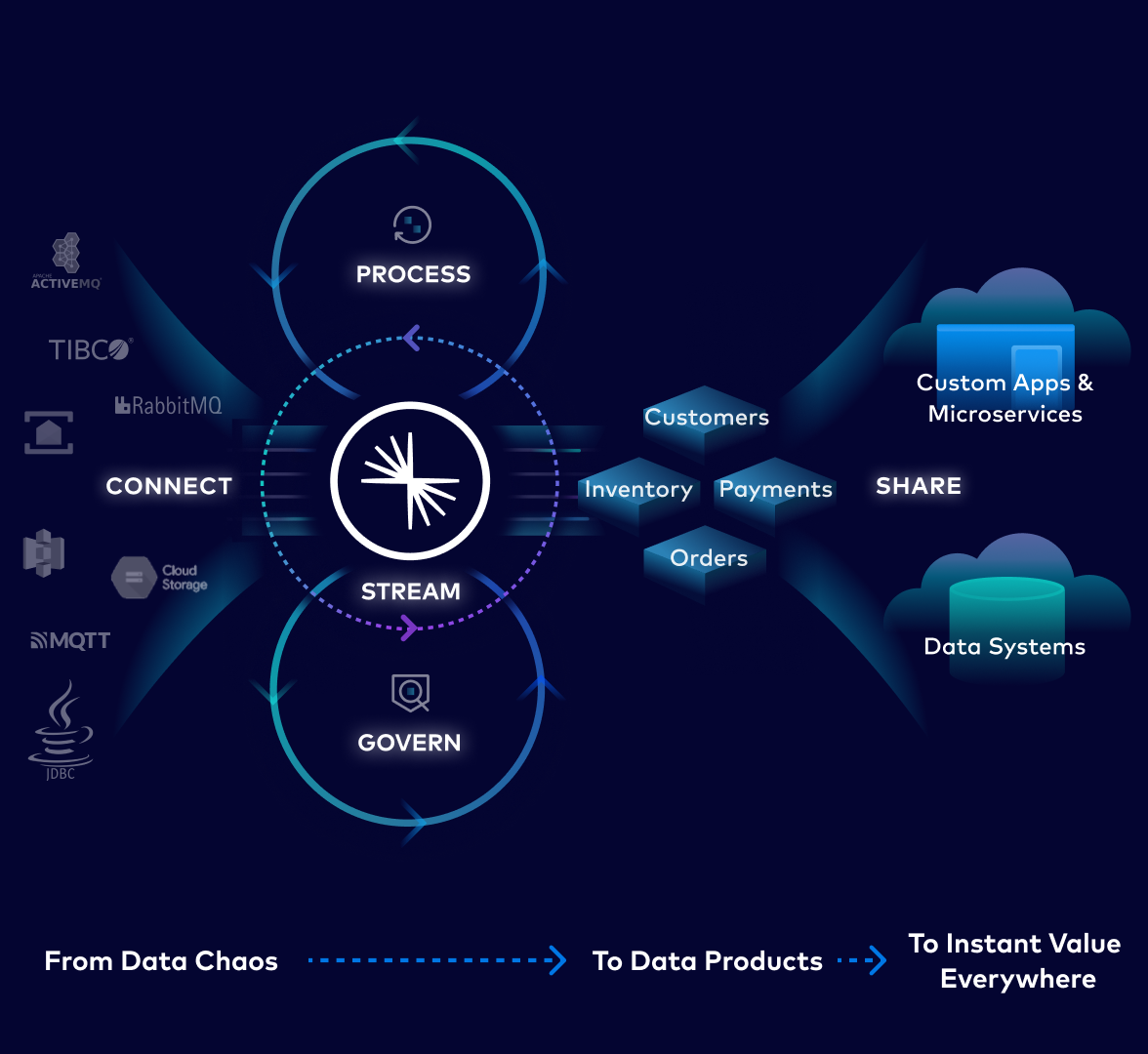

So funktioniert Confluent

Unternehmensweites Daten-Streaming beschleunigt die Anwendungsentwicklung und macht die Architektur zukunftssicher.

Streamen

Echtzeit-Datenströme optimieren und mit einer oder mehreren Anwendungen in Echtzeit austauschen

Verbinden

Daten aus bestehenden Services und Anwendungen mit vorgefertigten oder benutzerdefinierten Connectors und Producer/Consumer-Funktionen integrieren und erschließen

Verarbeitung

Erstellen wiederverwendbarer Datenprodukte durch kontinuierliche Aggregation, Verarbeitung und Anreicherung mit anderen Quellen aus dem gesamten Unternehmen

Verwalten

Daten, Metadaten und Abhängigkeiten problemlos ermitteln. Zentrales Tagging, Auditing und die Anwendung von Policies ermöglicht die Erstellung vertrauenswürdiger und hochwertiger Datenprodukte

Weitergabe

Die kontinuierliche Nutzung aktueller, angereicherter und vertrauenswürdiger Datenprodukte in hybriden Cloud-, Multiregionen- oder Multicloud-Umgebungen ermöglichen

Unsere Partner helfen bei der Umsetzung von Daten-Streaming

Confluent ergänzt die bisherigen Investitionen in Daten und ermöglicht es Unternehmen, vertrauenswürdige Daten in Echtzeit über den gesamten Stack zu verteilen.

Cloud-Partner

Technologiepartner

Systemintegratoren

Eine Plattform. Unbegrenzte Anwendungsfälle.

Ressourcen

Noch heute mit Confluent Cloud loslegen

Ein vollständig verwalteter Service, der elastisch, zuverlässig und wirklich Cloud-nativ ist, ermöglicht einen um mehr als 60 % effizienteren Betrieb und einen ROI von 257 %. Jetzt loslegen.