[Virtuelles Event] GenAI Streamposium: Lerne, Echtzeit-GenAI-Apps zu entwickeln und zu skalieren | Jetzt registrieren

Weniger Datenbereinigung. Mehr Entwicklung.

Ein Shift-Left-Ansatz bei der Verarbeitung und Verwaltung von Daten hilft dabei, den ROI auf Data-Warehouses zu maximieren. Datenqualitätsprobleme können um bis zu 60 % reduziert, Rechenkosten um 30 % gesenkt und gleichzeitig die Engineering-Produktivität verbessert werden.

Shift Left: Mit Datenprodukten Operations und Analytics vereinen

E-Book lesen

Was ist eine Headless Data Architecture?

Video ansehen

Confluent arbeitet mit Snowflake am Polaris Catalog für Apache Iceberg zusammen

Blog-Beitrag lesenVerarbeiten und verwalten links. Einsparungen rechts.

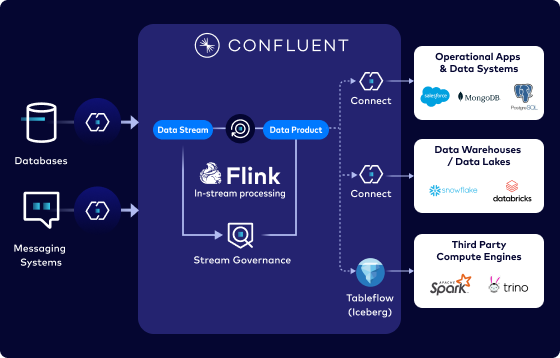

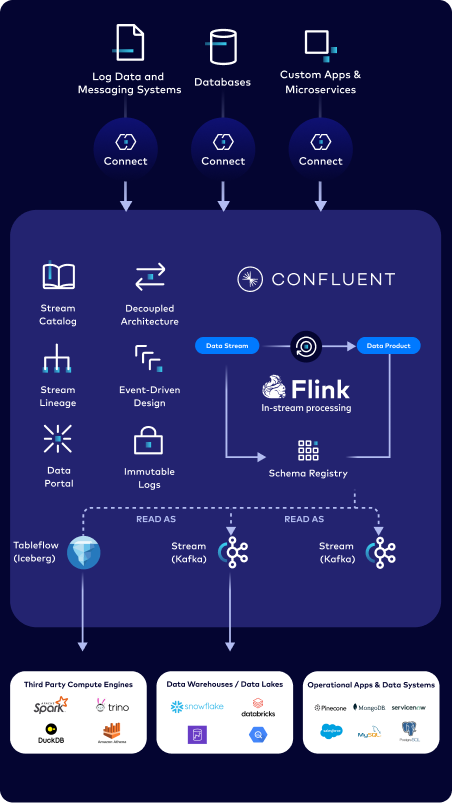

Aktuellste Daten für Analysen bereitstellen

Jederzeit High-Fidelity-Daten bereitstellen, die kontinuierlich fließen, sich weiterentwickeln und mit Echtzeit-Daten-Streaming und In-Flight verarbeitet werden.

Einsatzbereite, vertrauenswürdige Datenprodukte liefern

Daten umgehend an verschiedene Kontexte anpassen und die Self-Service-Suche und Auffindbarkeit unternehmensweit ermöglichen.

ROI-Maximierung bei Data-Warehouses und Data Lakes

Daten nur einmal an der Quelle verarbeiten und verwalten. Datenqualitätsprobleme um 40–60 % reduzieren, damit sich das Data-Engineering-Team auf strategisch wichtigere Projekte konzentrieren kann.

Daten aus operativen Systemen sofort verbinden und streamen

Sofort einsatzbereite Connectors

Mehr als 120 selbstverwaltete und mehr als 80 vollständig verwaltete Zero-Code- und CDC-Connectors ermöglichen die sofortige Konnektivität zu vorhandenen Datensystemen

Custom Connectors

Eigene Connectors nutzen und sicher und kostengünstig über unseren vollständig verwalteten Cloud-Service einsetzen

Native Cloud-Integrationen

Sofortiger Zugriff auf Streaming-Daten direkt in AWS, Azure und GCP, ohne das bevorzugte Tool verlassen zu müssen

Einmal entwickeln. Richtig entwickeln. Überall wiederverwenden

Bereinigung direkt an der Quelle

Streams umgehend bereinigen, filtern, verbinden und anreichern, um die Daten-Wiederverwendung zu fördern

Inkrementell verarbeiten

Kontinuierliche Verarbeitung, um in Millisekunden inkrementell aktualisierte Datenansichten bereitzustellen

Batch- und Echtzeitverarbeitung ermöglichen

Stream-Verarbeitung, Batch-Verarbeitung und ad hoc-Analysen mithilfe einer einheitlichen API

Bevorzugte Programmiersprache nutzen

Java, Python und SQL mit mehr als 150 integrierten Funktionen

Self-Service-Zugriff auf vertrauenswürdige Datenprodukte ermöglichen

Datenqualität ab der Quelle garantieren

Vertrauenswürdige, qualitativ hochwertige Datenprodukte mit eindeutigen Datenverträgen und Schema-Management erstellen

Wiederverwendbare Datenprodukte nutzen

Daten-Consumers ermöglichen, via Data Portal und sicherem Self-Service Datenprodukte zu suchen und wiederzuverwenden

Streaming und Analysen vereinen

Kafka Topics und zugehörige Schemata mit Tableflow und einem Klick in Iceberg-Tabellen umwandeln

„[Datenbereinigung] Es ist eine kostspielige Methode, sie in den Deltalake zu verschieben. Die Deduplikation in Confluent ist die günstigere Variante. Wir müssen es nur einmal machen.“

„Ich bin ein großer Fan des [Shift Left]-Ansatzes. Auf diese Weise würden wir Datensätze leichter auffindbar machen. Ich wusste, dass Confluent eine Integration mit Alation hat, aber es ist großartig zu hören, dass ihr auch andere Wege [Data Portal] habt, um diese Funktionen zur Verfügung zu stellen.“

Confluent + Partner beschleunigen die Einführung

Gemeinsam mit unseren Partnern maximieren wir den Nutzen hochwertiger Datenprodukte im gesamten Ökosystem.

Cloud-Anbieter

Unabhängige Softwareanbieter

Systemintegratoren