[Virtuelles Event] GenAI Streamposium: Lerne, Echtzeit-GenAI-Apps zu entwickeln und zu skalieren | Jetzt registrieren

Data Streaming for Real-time Artificial Intelligence

Build next-generation data-intensive AI applications with Confluent Data Streaming Platform. Tap into continuously enriched, trustworthy data streams to quickly build and scale real-time AI applications.

Build a Real-time Data Foundation for AI

Make real-time contextual inferences on an astonishing amount of data by bringing well curated, highly governed, trustworthy streaming data to your AI systems, vector databases, agents, and applications.

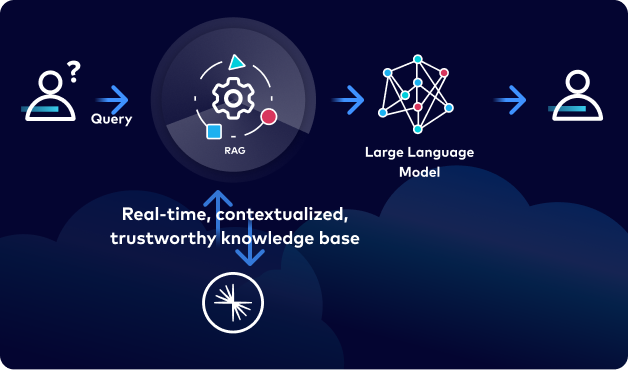

Create a real-time knowledge base

Build a shared source of real-time truth for all your operational and analytical data, no matter where it lives for sophisticated model building and fine-tuning.

Bring real-time context at query time

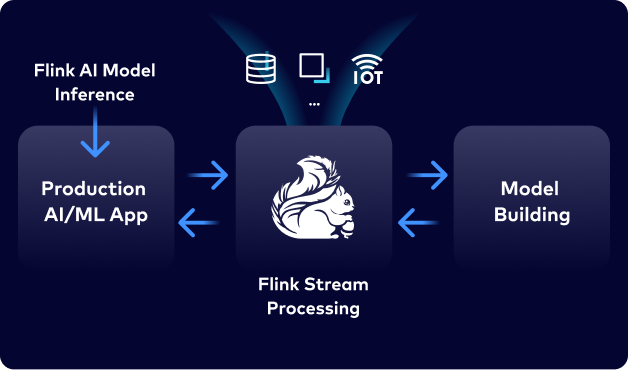

Use Flink stream processing, AI model inference, and create embeddings action to continuously enrich data and update your vector databases.

Experiment, scale and innovate faster

Reduce innovation friction as new AI apps and models become available. Decouple data from your data science tools and production AI apps to test and build faster.

Build governed, secured, and trusted AI

Establish data lineage, quality and traceability, providing all your teams with a clear understanding of data origin, movement, transformations and usage.

Explore AI Use Cases

Why Confluent

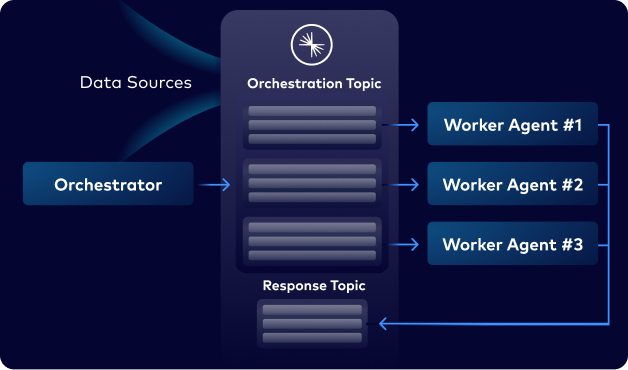

Using Confluent Data Streaming Platform, stream all your data in real time from everywhere, curate and govern them while in flight to deliver production-scale AI-powered applications faster.

Stream

Make real-time data streams first-class citizens and enable them to be shared to one or more AI systems and applications in real time.

Connect

Integrate data from and to existing services and apps with 120+ pre-built and custom connectors, including integrations with leading AI tools.

Process

Use Flink to enrich relevant data streams on the fly. Use any model from within FlinkSQL to interrogate and transform data with natural language.

Govern

Centrally manage, audit, and apply policies with Stream Governance. Secure data in transit with private networking across all the major public clouds.

Featured Resources

Leverage Confluent as the data orchestration layer for your AI stack, bringing real-time contextualized data to any LLM, vector database, agent, and application across any cloud. Sign up today and receive $400 credits.